新闻中心

解决谷歌搜索引擎无法访问robots.txt文件方法-由于无法访问 robots.txt 文件,因此 Google 无法抓取您的网站。

首先大家对robots.txt文件的作用都知道吧,蜘蛛首先要爬取你网站中的robots.txt文件,如果无法访问的robots.txt文件,那么你的网站就无法控制所有的蜘蛛抓取,像一些小有名气的爬虫,我们是可以避免让其爬行的,禁止的话,就需要在这个文件操作。那么我不想完好控制谷歌爬虫来爬取,而谷歌爬虫无法访问robots.txt文件,并且提示如下英文信息。

现象描述:google提示:Unreachable: robots.txt Using a web browser, attempt to access http://www.fc2hermes.com/robots.txt. If you are able to access it from your browser, then your site may be configured to deny access to googlebot. Check the configuration of your firewall and site to ensure that you are not denying access to googlebot.

查看错误记录:登陆你的谷歌站长工具,并选中你想查询网站的域名,左边的信息中心>>抓取>>Google抓取方式,内容如下图所示: 问题分析:这个是网站设置目标地理区域不同,导致google蜘蛛的IP地址无法访问到你的网站文件。

解决方法:

登陆你的谷歌站长工具,选中点你要设置的域名。

然后在右上角“帮助”边上的齿轮点一下

问题分析:这个是网站设置目标地理区域不同,导致google蜘蛛的IP地址无法访问到你的网站文件。

解决方法:

登陆你的谷歌站长工具,选中点你要设置的域名。

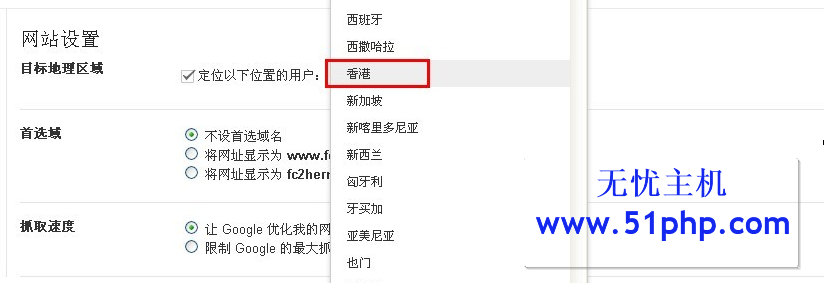

然后在右上角“帮助”边上的齿轮点一下 ,会出现“网站设置”,进去后,就可以看到“目标地理位置”,改成“香港”。如下图所示:

,会出现“网站设置”,进去后,就可以看到“目标地理位置”,改成“香港”。如下图所示: 注:目标地理区域默认是美国,用户使用的是无忧主机香港空间,所以这个需要设置成“香港”即可,也可以选择大陆,这个主要看你的选择,因为谷歌在不同的地区有不同蜘蛛来爬去内容。更重要的是,谷歌在大陆的事件,做站长的都懂的,大陆就不太建议选择。大家可以尝试变更网站的区域,引导谷歌的蜘蛛来爬取网站。

注:目标地理区域默认是美国,用户使用的是无忧主机香港空间,所以这个需要设置成“香港”即可,也可以选择大陆,这个主要看你的选择,因为谷歌在不同的地区有不同蜘蛛来爬去内容。更重要的是,谷歌在大陆的事件,做站长的都懂的,大陆就不太建议选择。大家可以尝试变更网站的区域,引导谷歌的蜘蛛来爬取网站。

本文地址:https://www.51php.com/others/13086.html